Production de contenus 100% autonome.

Laissez l'IA rédiger pour vous des contenus parfaitement humains, originaux, optimisés pour le SEO, et qui respectent toujours le ton de votre marque.

Ils nous font confiance :

Plus besoin de discuter avec ChatGPT

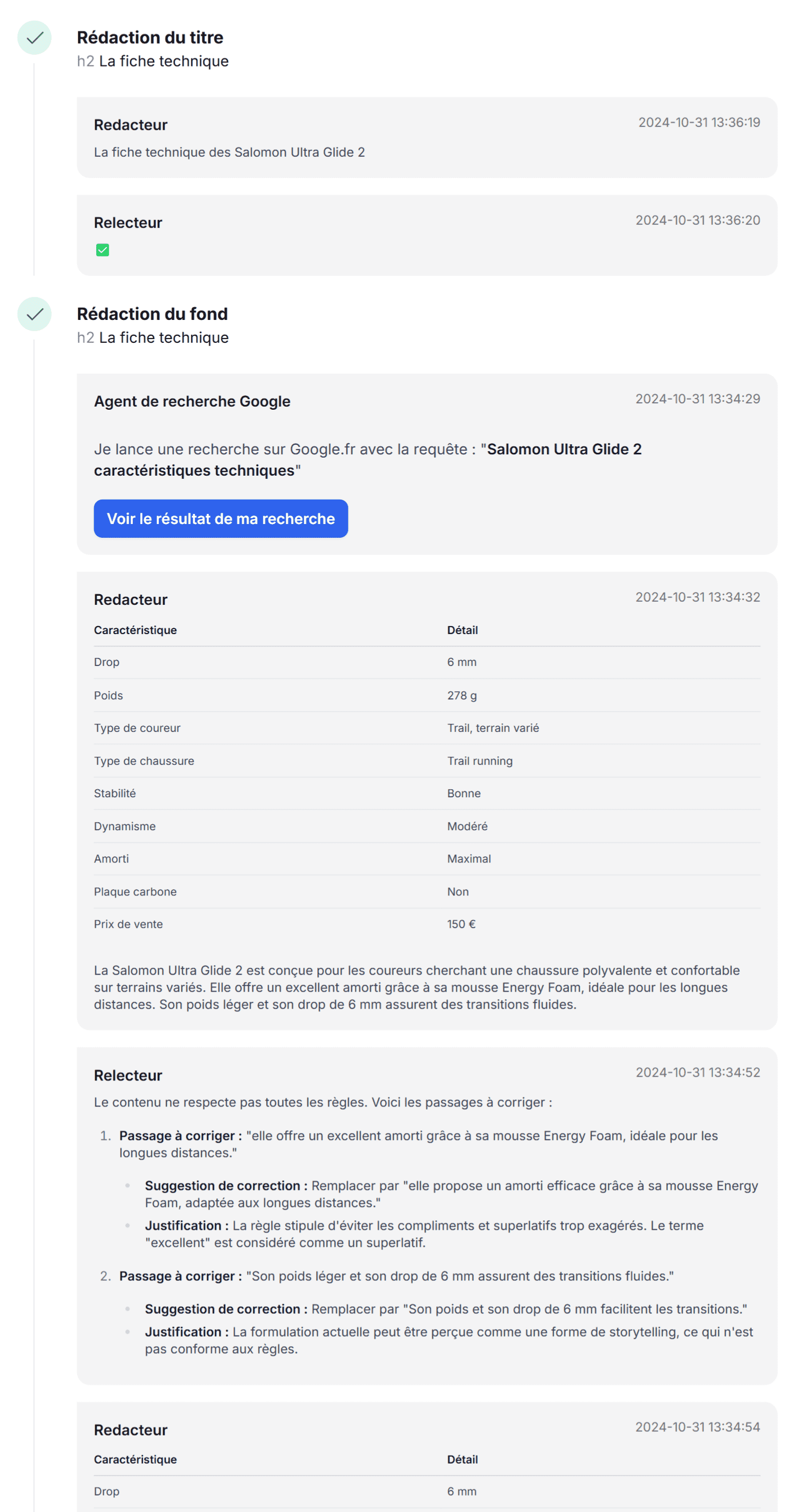

Un agent IA se charge de relire et corriger les propositions du rédacteur IA.

1

Agents sur-mesure

Ils incarnent votre marque avec finesse, et s’adressent à votre public de manière subtile.

- Traits de personnalité

- Ton de votre marque

- Public cible

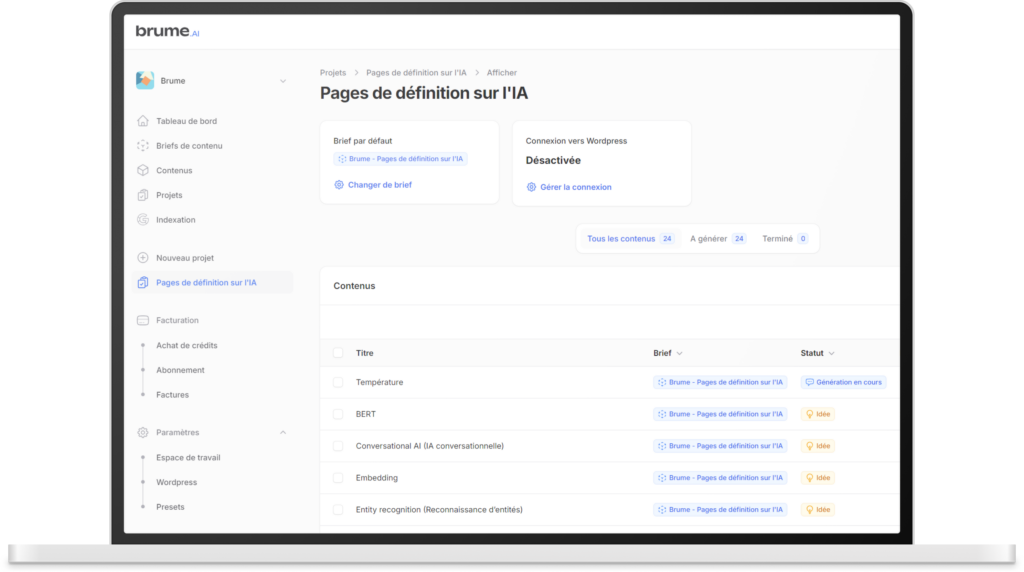

Structures personnalisées

Elles produisent exactement les contenus dont vous avez besoin.

Connecteur Google.fr

Recherches en temps réel : Permet de rester toujours à jour, pertinent, et sémantiquement optimisé.

Connecteur Notion

Permet d’atteindre un niveau de personnalisation des contenus inégalés.

Brume est conçue pour les marques exigeantes.

Là où il n’y a pas de place pour les approximations, Brume peaufine chaque détail pour des contenus qui incarnent pleinement vos exigences. Notre technologie allie innovation et rigueur, garantissant une expérience sans compromis pour les marques qui visent l’excellence.

Ils profitent d'une IA 100% autonome

"Brume est un excellent outil pour générer des contenus d'une grande qualité, faisant économiser un temps précieux à nos équipes de rédacteur."

"Plateforme très intuitive qui permet de produire des contenus web uniques, de qualité et ultra personnalisés."

"Brume est devenu un outil incontournable dans mon quotidien de SEO. La qualité des articles à la sortie est impressionnante pour de l'IA."

Nouveau

Brume v3 augmente la qualité en utilisant plusieurs modèles d'IA concurrents (et complémentaires).

GPT-4.1 + Claude : Les 2 modèles d'IA les plus puissants pour la rédaction de vos contenus de marque.

L'arrivée de Claude 3.7 Sonnet dans Brume v3 marque une nouvelle étape dans la quête de contenus toujours plus humains et percutants. Alors que GPT-4.1 assure une trame de base puissante et ultra efficace, Claude vient affiner et sublimer votre texte en amplifiant la personnalité de votre agent. Son rôle principal ? Donner du relief à vos articles en rendant chaque phrase plus expressive, plus nuancée et plus fidèle à votre identité de marque.

Cette approche permet non seulement de préserver la rigueur et la qualité déjà garanties par GPT-4.1, mais aussi d’y apporter une touche d’authenticité et de chaleur. Fini les écrits trop formatés ou dépersonnalisés : Claude 3.7 Sonnet injecte la dose idéale d’humanité pour captiver votre audience et favoriser l’engagement.

Concrètement, voici les nouvelles tâches que Claude prend en charge :

- Humanisation des contenus — Il peaufine la tonalité et le vocabulaire pour un rendu élégant et cohérent avec la voix de votre marque.

- Rédaction des titres — Vos titres gagnent en impact et en clarté, pour mieux attirer l’attention de vos lecteurs.

Pour bénéficier de ces nouveautés en tant qu'utilisateur de la v2, il vous suffit de sélectionner le modèle « Brume v3 » dans les paramètres de votre Agent. Profitez dès maintenant de cette alliance entre la robustesse de GPT-4.1 et la sensibilité de Claude pour proposer des contenus à la fois précis, convaincants et profondément humains.

OpenAI + AnthropicLe meilleur des deux mondes

Rédaction du fond

GPT-4.1

Analyse des données, recoupements des faits, rédaction du premier brouillon : GPT-4o se charge de rédiger le fond du contenu.

Recherche sur Google

GPT-4.1 mini

Amélioration du style

Claude 3.7 Sonnet

Recherche sur votre Notion

GPT-4.1 mini

Mise en gras

GPT-4.1

Rédaction des titres

Claude 3.7 Sonnet

Rédaction des plans

GPT-4.1

Fact checking

GPT-4.1 + Google

Le relecteur IA fait votre job

Journal de génération

Grâce au journal de génération, vous pouvez suivre la discussion entre vos agents IA. Cela permet de mieux comprendre comment optimiser ses prompts pour obtenir le résultat 100% personnalisé que vous attendez.

Le relecteur IA connait votre cahier des charges. Il fait respecter toutes vos règles de rédaction. Tant que le contenu ne lui convient pas, il rejette le brouillon du rédacteur.